“Stop Killer Robots”: preoccupazione per il sistema di elaborazione dati Lavender utilizzato da Israele a Gaza

La Campagna Stop Killer Robots continua a ritenere le notizie sull’uso da parte di Israele di sistemi di Intelligenza Artificiale per la scelta di obiettivi militari nella Striscia di Gaza profondamente preoccupanti da un punto di vista legale, morale e umanitario

Sebbene il sistema Lavender, come già il sistema Habsora/Gospel, non sia un’arma autonoma, entrambi sollevano serie preoccupazioni sull’uso crescente dell’intelligenza artificiale nei conflitti, sui pregiudizi insiti nelle forme di automazione, sulla disumanizzazione digitale e sulla perdita del controllo umano nell’uso della forza.

Le notizie secondo cui Lavender sia stato utilizzato dall’IDF per determinare obiettivi umani sono profondamente preoccupanti. Secondo quanto riferito, il sistema fornisce raccomandazioni per il targeting basate su “caratteristiche” comportamentali, tra cui modelli di comunicazione, connessioni ai social media e cambi di indirizzo frequenti. Secondo una fonte del portale giornalistico israeliano +972, “un individuo che presenta diverse caratteristiche incriminanti raggiungerà un punteggio elevato e quindi diventerà automaticamente un potenziale obiettivo per un’uccisione”.

Il Lavender è un sistema di elaborazione dati, non un’arma autonoma, e la decisione di colpire o meno un bersaglio raccomandato viene presa ed eseguita separatamente da un essere umano e non da una macchina. Tuttavia, l’uso di questo sistema dimostra i problemi principali delle armi autonome, ovvero la disumanizzazione digitale e la perdita di un controllo umano significativo.

La protezione dei civili è un principio fondamentale del Diritto Internazionale Umanitario (DIU) e, in caso di dubbio sullo status di un individuo, questo deve essere considerato un civile. La classificazione della popolazione civile di Gaza come potenziale bersaglio sulla base di profili comportamentali, che hanno un margine di errore del 10%, riduce gli esseri umani a meri “insiemi di dati” e solleva gravi preoccupazioni in merito al rispetto del Diritto internazionale umanitario, alla violazione della dignità umana e alla disumanizzazione digitale.

Inoltre, sono preoccupanti i resoconti di “un’approvazione generalizzata da parte degli ufficiali per l’adozione delle liste di uccisioni di Lavender, senza alcun obbligo di controllare a fondo il motivo per cui la macchina ha fatto quelle scelte o di esaminare i dati di intelligence grezzi su cui si basavano”. La mancanza di un controllo e di un impegno umano significativo nelle decisioni di attaccare gli obiettivi raccomandati da Lavender dimostra una tendenza preoccupante nell’affidarsi a sistemi automatizzati.

La Campagna Stop Killer Robots (di cui anche Rete Pace Disarmo fa parte) ritiene che la tecnologia debba essere sviluppata e utilizzata per promuovere la pace, la giustizia, i diritti umani, l’uguaglianza e il rispetto della legge – non per uccidere in modo autonomo o per consolidare o riprodurre ulteriormente le disuguaglianze e l’oppressione.

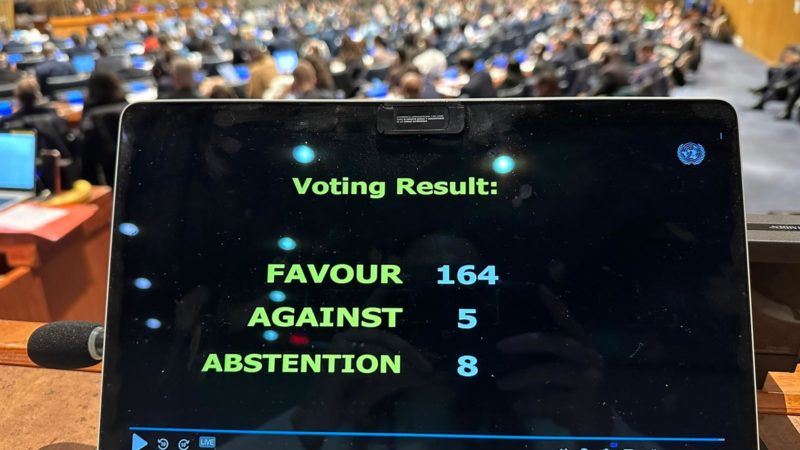

Il Segretario generale delle Nazioni Unite, il Comitato internazionale della Croce Rossa e più di 100 Paesi hanno chiesto uno strumento giuridico sui sistemi di armi autonome. L’uso sempre più frequente di sistemi con livelli di autonomia diversi dimostra l’urgente necessità di divieti e regolamenti chiari sull’autonomia dei sistemi d’arma nel diritto internazionale.